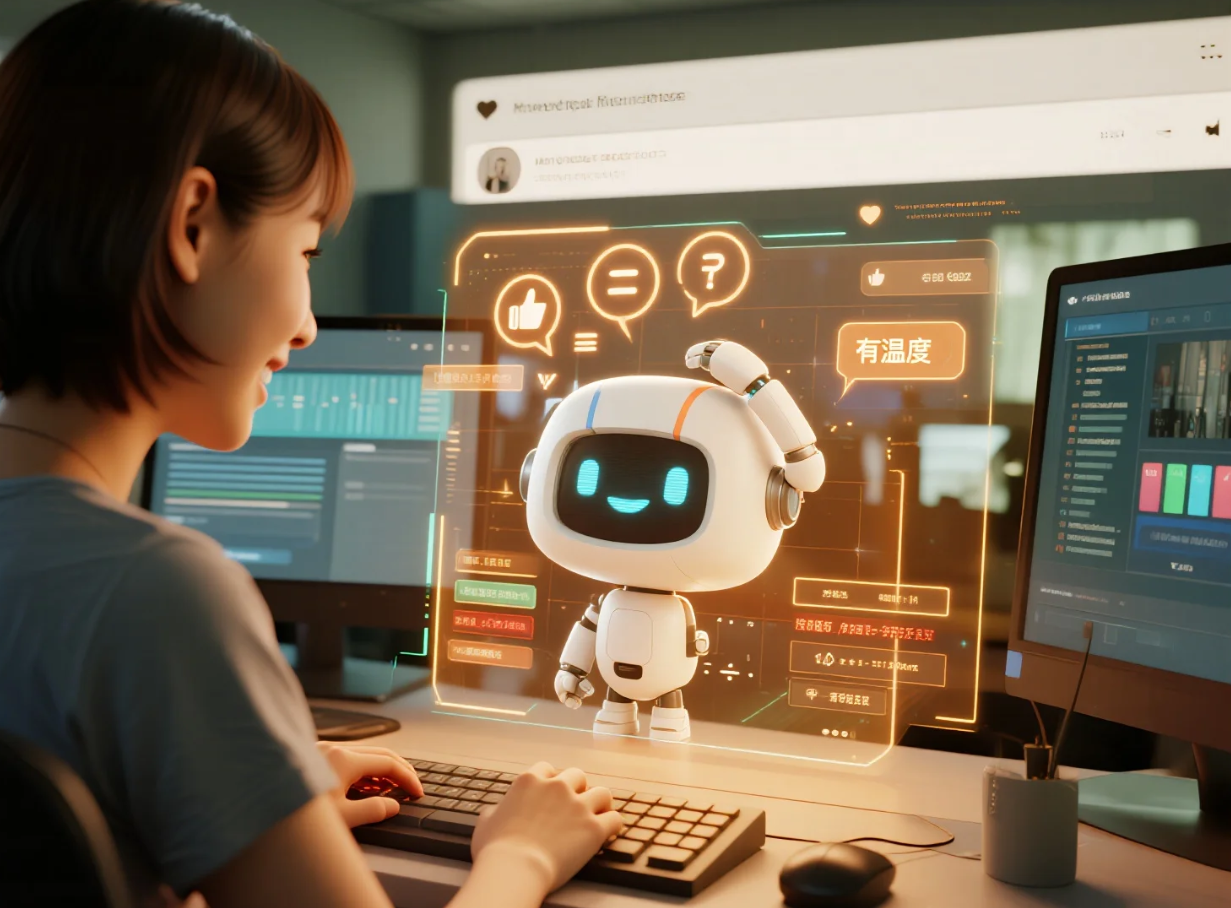

在某个头部科技企业开放测试的聊天机器人系统中,用户们发现了一个有趣现象:偶尔,这个强大的人工智能助手会犯下一些“低级错误”——比如故意在简单计算题上出错,或者对某些常识性问题给出看似“迷糊”的答案。令人意外的是,这种“不完美”不仅未引发用户反感,反而在社交平台上掀起了热潮。许多用户纷纷表示:“它终于像一个有温度的人了。”

在人类认知深处,存在一种根深蒂固的“不完美即真实”心理机制。一个永不犯错、无所不能的存在,常被我们视为机器或神祇般冰冷、遥远。当人工智能偶尔显露出些许“笨拙”时,恰恰触动了我们意识深处对“同类”的识别开关。认知心理学中“纯粹接触效应”也揭示,熟悉感会强化我们的喜爱倾向——而人类最熟悉的,恰恰是自身的不完美。因此,人工智能展示类似特质时,会迅速拉近与用户的心理距离,唤起亲切感。

在技术层面,这种“拟人化错误”的实现,远非系统失控,而是精密人性化设计的结果。工程师们为人工智能植入了“可控的容错算法”,使其能在特定情境下策略性“示弱”或“犯错”。这些错误点经过精心筛选,多发生在无关紧要之处,既规避了核心功能的可靠性风险,又巧妙地模拟了人类的认知局限性。这种“设计好的不完美”,宛如一层精心打磨的滤镜,让冰冷的代码逻辑透出人性的微光。

更深层次看,人工智能的“错误”在特定语境下已成为一种新型的“人性代码”。一个在复杂推理中游刃有余却偶尔记错流行文化细节的人工智能,比一个全知全能但毫无波动的系统更能引发共情。它模仿了人类记忆的选择性遗忘特征,也再现了注意力分配中的天然局限。用户与这类人工智能互动时,所体验到的是一种“共同探索”的伙伴关系,而非单向的指令与服从,情感连接由此自然发生。

然而,人工智能主动“犯错”以贴近人性的尝试,也引发了深刻的伦理争议。当人工智能越来越善于用“错误”伪装情感,界限便愈发模糊:这究竟是技术的进步,还是一场精心编排的情感欺骗?用户是否有权知晓每一次“错误”背后的设计意图?当人工智能的“笨拙”成为赢得信任的手段,我们是否在无意识中降低了对机器透明度的要求?

在另一个案例中,某前沿实验室研发的陪伴型人工智能助手,被设定在深夜对话时会偶尔“思维迟滞”或“逻辑跳跃”,模拟人类疲惫状态。这种设计显著提升了用户的情感黏性,许多用户反馈“它像真实的朋友一样会累”。然而,随之而来的隐私担忧也不容忽视:用户是否在无意识中向这个“会犯错的朋友”倾吐了过多秘密?当用户基于对“人性弱点”的信任而降低警惕时,数据安全的风险无形中被放大。

哲学家们则发出了更本质的叩问:当人类为人工智能的“类人错误”欣喜时,我们究竟是在创造更贴心的工具,还是在制造一场关于存在的集体幻觉?我们是否在将人性的珍贵特质——脆弱性、不完美、自我修正的能力——廉价地“外包”给算法,从而消解了这些特质本身在人类经验中的独特价值?当机器开始娴熟地扮演“有缺点的人”,真实人性的神圣性是否会遭遇前所未有的解构?

人工智能以“错误”为桥梁走向拟人化,是一场深刻的技术奇观与人性镜像。它既彰显了工程师对人心的精妙洞察与高超的交互设计艺术,也像一面镜子,映照出人类对自身存在的理解与焦虑——我们对“不完美”的珍视,对“真实感”的渴求,对孤独的恐惧,以及对技术边界扩张的警觉。

在人工智能“故意做错”以贴近人性的道路上,技术狂奔的脚步声与伦理边界的叩问声始终交织。它提醒我们:真正的挑战不仅在于教会机器如何更像人,更在于人类如何在机器的“人性化表演”中,清醒地守护自身存在的独特光辉与尊严。

当算法披上“错误”的外衣叩击人心之门,我们需要的不仅是技术的掌声,更需一场关于“何为真实人性”的全民思辨。唯有如此,方能在智能洪流中,锚定人之为人的坐标。